前言:一次意外的"创作实验"

昨天,我发布了一篇《如何用 Cloudflare + Vercel 省钱指南》的技术文章,2万多字,涵盖6个应用场景,包含详细的成本分析、真实案例和实操指南。

文章发布后,很多读者除了关心省钱方案,更好奇的是:"这篇文章是怎么写出来的?你和AI是如何协作的?"

今天我就来完整复盘这个过程,分享一些AI协作写作的心得。这不是一篇AI吹嘘文,而是一次真实的协作记录,包括踩过的坑、犯过的错,以及如何一步步优化出高质量内容。

第一阶段:人类构思,AI执行

起因:发现真实需求

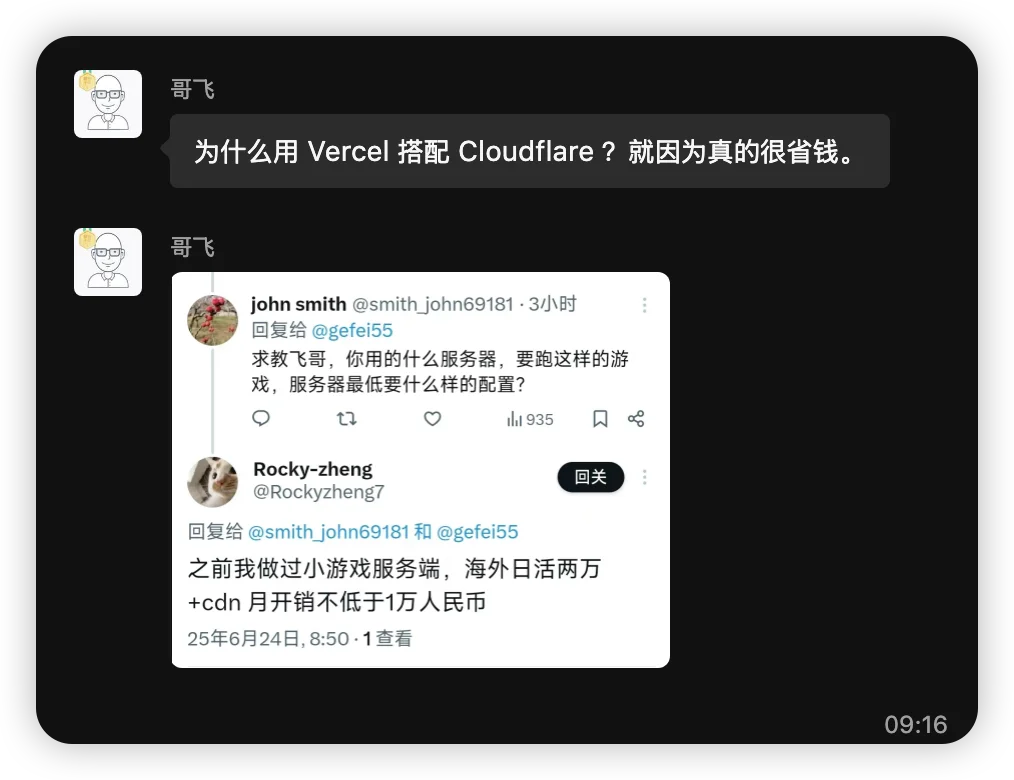

作为产品,我经常看到哥飞的群里有人抱怨:

"Vercel账单又暴涨了"

"有没有便宜的部署方案?"

"Cloudflare免费的那些服务靠谱吗?"

原图来自哥飞的群

原图来自哥飞的群

我意识到这是一个普遍痛点:大家想要现代化的开发体验,但不想为此付出太高的成本。

市面上虽然有零散的教程,但缺少系统性的、针对中国开发者的成本优化指南。于是我决定写一篇深度文章。

初始对话:设定框架

我向Claude提出了需求:

"我想写一篇关于如何用Cloudflare配合Vercel省钱的教程,面向大陆程序员,要实用、要有具体数据、不能写成软文。"

Claude的回应让我眼前一亮。它不是直接开始写,而是先问了几个关键问题:

目标读者的技术水平?

要覆盖哪些具体场景?

希望达到什么样的省钱效果?

需要什么样的论证方式?

这种"先理解需求"的方式,比我预期的要好。

大纲制定:结构化思考

接下来,Claude提出了一个详细的文章大纲:

1. 现状摸底 - 钱都花哪儿了?

2. 分场景省钱策略 - 不同项目不同打法

3. 技术实现细节 - 具体怎么搭建

4. 成本详细对比 - 算账算到底

5. 实战案例深度剖析

6. 迁移步骤和注意事项

我对这个结构很满意,但提出了一个要求:

"举例中缺少了一些具体的案例,比如说博客、导航站、页游网站、saas服务、数据库、API调用等这些"

Claude立即补充了6个具体场景,每个都有详细的技术栈和成本分析。这种快速响应和补充的能力,是人类写作很难达到的。

第二阶段:内容生成,意外很多

第一稿:看起来很完美

Claude开始写正文,速度很快,10小时不到就产出了近2万字的内容,包括:

详细的价格对比表格

6个场景的技术方案

具体的成本计算

4个深度案例分析

我当时的第一反应是:"这也太强了吧!"

内容结构清晰,数据详实,案例丰富,技术细节到位。如果直接发布,绝对是一篇高质量的技术文章。

但是,我决定先做一次全面审核。

审核阶段:发现大问题

我让Claude扮演审核校对的角色,重点检查:

计算数据/账单是否正确?

所有推荐的库/开源项目都要有链接

所有的组合方案是否真实可行?

错别字和内容纠正

结果发现了一个重大错误:

文章中声称Vercel Pro超出100GB后按$0.40/GB收费,实际上是$0.15/GB,而且Pro Plan有1TB的Fair Use Guidelines!

这个错误导致了:

成本计算完全错误

节省比例被夸大(从98%降到实际的50-75%)

年度节省金额从不现实的$4,500调整到$360

教训:AI会"编造"数据

这次错误让我意识到一个重要问题:AI有时会生成看起来很合理但实际错误的数据。

可能的原因:

训练数据中的过时信息

对不确定信息的"合理推测"

为了让论证更有力而"优化"数据

这就是为什么人类审核如此重要。

第三阶段:事实核查,追求客观

多平台数据校验

发现错误后,我意识到单一AI源的数据验证是不够的。于是我采用了多方验证策略:

Claude的实时搜索:搜索最新的官方定价信息

Claude的Advanced Research:对复杂的技术问题进行深度研究

Grok的Deep Think:用不同的AI视角重新分析数据

人工官网核实:直接查看官方定价页面

这种"三角验证"方法显著提高了数据的准确性。比如Vercel的定价问题:

Claude初始数据:$0.40/GB(错误)

搜索验证后:$0.15/GB(正确)

Grok交叉验证:确认$0.15/GB

官网最终确认:$0.15/GB + Fair Use Policy

关键发现:不同AI平台对同一问题可能给出不同答案,多方验证是必要的。

添加真实的负面反馈

我意识到文章读起来像"软文",全是好处没有缺点。于是我要求:

"可以收集一些网友反馈的缺点和不稳定性之类的作为对比说明。毕竟我们不是写软文"

Claude搜索了真实的用户反馈,包括:

Cloudflare 2025年6月的2小时故障

用户遇到的Workers冷启动问题

D1数据库$3200巨额账单案例

Vercel团队成员收费导致的用户流失

这些负面信息的加入,让文章更加客观和可信。

补充实用链接

原文提到了很多开源项目和工具,但没有链接。我要求Claude为每个推荐的工具添加官方链接,方便读者直接使用。

第四阶段:平衡与完善

结构重组

经过几轮修改,文章从原来的6个部分扩展到13个部分:

现状摸底

分场景策略

技术实现

成本对比

实战案例

真实用户反馈(新增)

迁移指南

进阶技巧

未来规划

常见问题

成功案例总结

行动计划

结语

新增的"真实用户反馈"部分是最重要的改进,它让文章从"营销文"变成了"客观分析"。

最终的人工把关

在每次重大修改后,我都会:

通读全文,检查逻辑一致性

验证关键数据的准确性

确保语言风格的统一

补充缺失的重要信息

我总结的AI协作最佳实践

经过这次深度协作,我总结出几个关键原则:

1. 人类负责"方向",AI负责"执行"

人类应该把控:

文章的核心价值和目标读者

内容的客观性和平衡性

关键数据的准确性验证

最终的质量把关

AI擅长处理:

大量信息的收集和整理

结构化内容的快速生成

多场景的详细分析

格式化和语言优化

2. 多轮迭代,不断优化

不要期待AI一次就能输出完美内容。我们的协作过程包括:

初稿生成

审核发现问题

搜索验证数据

补充客观信息

结构调整

最终润色

每一轮都在解决不同层面的问题。

3. 保持质疑精神

对AI生成的内容,特别是数据和案例,要保持怀疑态度:

数字是否准确?

案例是否真实?

结论是否客观?

逻辑是否自洽?

4. 善用AI的搜索能力

现在的AI可以实时搜索最新信息,这是巨大的优势。但要明确指出搜索需求:

"搜索最新的官方定价"

"找真实的用户反馈和负面评价"

"验证这个技术方案的可行性"

5. 多平台交叉验证

单一AI源不可靠:

Claude可能有训练数据时效性问题

不同AI的知识库可能有差异

搜索结果的解读可能不同

我的验证流程:

Claude实时搜索获取初始数据

用Grok的Deep Think重新分析

Claude的Advanced Research深度研究

人工查阅官方文档确认

多个数据源对比验证

实际案例: Vercel定价验证:

Claude初始:$0.40/GB(错误)

搜索后:$0.15/GB(修正)

Grok验证:确认$0.15/GB

官网核实:$0.15/GB + Fair Use Policy

最终采用:经过三方验证的准确数据

这种"三角验证"虽然耗时,但显著提高了内容的可信度。

6. 强调客观性

如果不主动要求,AI往往倾向于生成"积极正面"的内容。要明确提出:

"不要写成软文"

"要包含负面反馈"

"要客观分析优缺点"

踩过的坑和避坑指南

问题:AI生成的数据看起来很专业,但可能是错误的。

解决:对所有关键数据进行多平台验证,特别是价格、性能指标等。

坑3:过度乐观陷阱

问题:AI倾向于强调优点,忽略缺点和风险。

解决:主动要求添加负面信息和客观分析。

坑4:链接缺失陷阱

问题:AI会提到很多工具和项目,但不主动提供链接。

解决:明确要求为所有推荐内容添加官方链接。

坑5:深度不够陷阱

问题:AI的分析可能停留在表面,缺少深度洞察。

解决:通过追问和要求具体案例来增加深度。

我的多平台AI协作工具箱

经过这次实践,我总结了一个实用的AI工具组合:

主力工具:Claude

优势:逻辑清晰,结构化能力强,实时搜索准确

适用:文章框架搭建、内容生成、事实查证

局限:可能过于"保守",有时缺少创新视角

辅助验证:Grok

优势:Deep Think模式提供不同思路,数据敏感度高

适用:关键数据的交叉验证、另类视角分析

局限:回答有时过于简洁

深度研究:Claude Advanced Research

优势:能进行长时间、多轮次的深度调研

适用:复杂技术问题的全面分析

局限:耗时较长,适合不急迫的深度内容

最终确认:人工核实

方法:直接查阅官方文档、社区反馈、实际测试

原则:对关键数据零容忍,必须人工确认

这种"多层验证"的方法虽然增加了工作量,但显著提高了内容质量和可信度。

这次协作让我对AI写作有了新的认识:

1. AI不是替代,而是增强

AI不会替代人类写作,但可以极大地增强写作效率和质量。关键是找到合适的协作模式。

2. 审核比生成更重要

AI生成内容很快,但审核和优化才是真正的价值所在。这需要人类的判断力和专业知识。

3. 客观性需要主动追求

AI默认不会主动提供负面信息,这需要人类明确要求。这对维护内容的客观性很重要。

4. 迭代是必须的

一次性产出完美内容是不现实的。多轮迭代、不断优化是高质量内容的必由之路。

对未来的思考

AI写作会如何发展?

我认为未来的趋势是:

AI的事实准确性会继续提升

人机协作的工具会更加完善

客观性和平衡性仍需要人类把控

深度洞察仍是人类的优势

意外的收获

对内容创作者的建议

建立多AI协作流程:不要依赖单一AI平台

学会交叉验证:用不同AI分析同一问题

保持人工把关:AI可以辅助,但不能替代判断

强化专业素养:审核和验证能力比以往更重要

建立信息源清单:知道哪里能找到最权威的信息

结语:协作的力量

通过这次深度协作,我们在1天内产出了一篇2万字的高质量技术文章。这在以前是不可想象的。

但这不是AI的胜利,也不是人类的胜利,而是协作的胜利。

AI提供了强大的信息处理能力,人类提供了价值判断和质量把控。两者结合,才能产出真正有价值的内容。

最重要的是,这种协作模式是可复制的。任何有专业知识的人,都可以通过类似的方法,与AI一起创作出高质量的内容。

给想要尝试AI协作写作的朋友几个建议:

明确你的角色:你是导演,AI是编剧

建立验证流程:多平台交叉验证关键数据

保持质疑精神:验证比生成更重要

追求客观平衡:主动要求负面信息

多轮迭代优化:完美来自不断改进

发挥人类优势:价值判断、专业知识、创意洞察

建立工具矩阵:Claude + Grok + Research + 人工核实

AI时代的内容创作,不是人vs机器,而是人+机器。

掌握这种协作能力,可能比学会单纯使用AI工具更重要。

这篇"创作揭秘"文章本身,也是我和Claude协作完成的。元内容的meta,有趣吧?😄

你觉得这种协作模式如何?欢迎在评论区分享你的AI协作经验。